(English version available here)

Les technologies d’hypertrucage de plus en plus sophistiquées obligent les législateurs du monde entier à renforcer les cadres juridiques afin de protéger la vie privée et la sécurité de leurs citoyens.

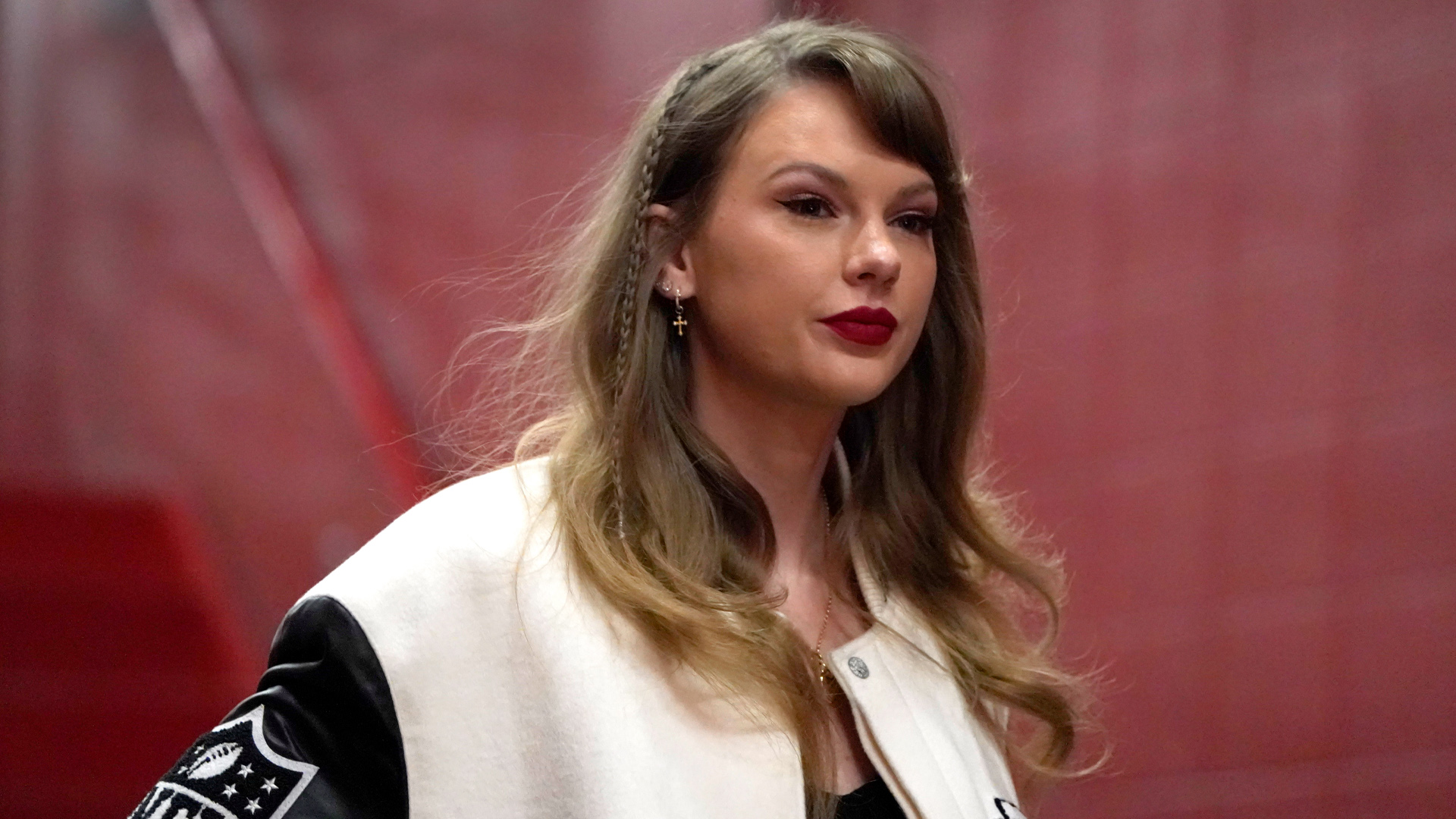

Les récents incidents liés aux hypertrucages – qui vont de la diffusion d’images sexuellement explicites censées mettre en scène Taylor Swift à la désinformation chinoise lors de l’élection présidentielle à Taïwan – montrent la nature vaste et complexe du problème de ces contenus créés par l’intelligence artificielle (IA) ou propulsés par elle.

Le problème s’aggrave à mesure que la technologie nécessaire à la production des hypertrucages devient plus accessible et plus facile à utiliser.

Certains gouvernements ont déjà pris des mesures pour encadrer leur utilisation. Malheureusement, le Canada semble avoir un ou deux pas de retard. Le pays a besoin dès aujourd’hui d’une nouvelle législation et d’autres mesures pour protéger ses citoyens et renforcer la résilience démocratique.

En comparaison, le Royaume-Uni a criminalisé le partage des hypertrucages pornographiques dans le cadre de la Online Safety Act de l’année dernière, tandis que la législation sur les services numériques de la Commission européenne a également abordé la question des hypertrucages pornographiques non consensuels.

En janvier, la No AI FRAUD Act a été présentée à la Chambre des représentants des États-Unis dans l’espoir d’établir un cadre fédéral d’action dans le sillage des hypertrucages sexuellement explicites de Taylor Swift.

Au Canada, huit provinces ont adopté une loi sur le partage d’images intimes non consensuelles – la Nouvelle-Écosse, l’Alberta, la Colombie-Britannique, la Saskatchewan, le Manitoba, le Nouveau-Brunswick, Terre-Neuve-et-Labrador et l’Île-du-Prince-Édouard –, mais seulement la moitié d’entre elles visent les images modifiées.

La Intimate Images Protection Act de la Colombie-Britannique donne aux procureurs le pouvoir de poursuivre les responsables de la diffusion en ligne de fausses images intimes non consensuelles. Cependant, elle ne s’adresse pas à la personne responsable de leur création ni aux grandes plateformes technologiques qui ont contribué à leur diffusion.

La facilité avec laquelle la technologie permet aujourd’hui de créer des hypertrucages est également une grave menace en termes d’influence étrangère malveillante, en particulier les campagnes de diffamation contre les candidats politiques ou les militants pour la démocratie et les droits de l’homme, notamment les femmes et les minorités raciales et sexuelles.

Les leçons à tirer de Taïwan

La tentative d’ingérence de la Chine dans les récentes élections présidentielles et législatives de Taïwan en est l’exemple type.

Des vidéos hypertruquées de Lai Ching-te, candidat victorieux du Parti démocrate progressiste à la présidence, ont été diffusées en ligne, le présentant faussement comme soutenant la coalition entre le Kuomintang et le Parti du peuple taïwanais, et diffusant un enregistrement où il critique prétendument son propre parti.

Ces hypertrucages chinois ont déformé ses déclarations originales dans le but d’influencer l’opinion publique et de saper le processus démocratique.

La Chine a tenté d’affaiblir Lai parce qu’il est favorable au maintien du statu quo actuel en ce qui concerne le statut politique de Taïwan, faisant valoir qu’elle est déjà indépendante, ainsi qu’au renforcement des relations avec les États-Unis et d’autres démocraties libérales.

Bien que les campagnes de désinformation chinoises n’ont pas eu d’impact significatif sur le résultat de l’élection, cette tentative a montré comment les hypertrucages pouvaient avoir un impact potentiel plus important sur les résultats d’élections dans d’autres pays, en particulier si le vote y est serré.

À mesure que la technologie se répand, ce problème ne peut que s’aggraver et les gens ciblés par l’hypertrucage disposent de peu de moyens pour lutter contre leur impact.

Peu de gens se mobilisent comme les admirateurs de Taylor Swift

Dans le cas de Taylor Swift, ses admirateurs ont eu recours au « hashjacking » (inonder le réseau de messages avec le mot-clic de la publication problématique pour l’enterrer dans le fil d’actualité) et à des plaintes auprès de X, anciennement Twitter, pour empêcher d’autres abus après la publication initiale.

Le problème est que peu de politiciens et de défenseurs des droits humains ou de la démocratie visés par des hypertrucages disposent d’un nombre aussi important de sympathisants qui se mobiliseraient d’eux-mêmes pour les protéger face à la diffamation.

En outre, il est de plus en plus facile de créer des hypertrucages réalistes toujours plus surprenants.

À la fin du mois de janvier, on estime qu’un faux appel téléphonique du président des États-Unis, Joe Biden, exhortant les électeurs démocrates à ne pas participer aux élections primaires dans le New Hampshire, a été fait entre 5000 et 25 000 fois. L’identifiant de l’appelant laissait faussement croire qu’il s’agissait de Kathy Sullivan, une ancienne présidente du parti démocrate de l’État qui a participé à la gestion d’un groupe politique pro-Biden.

Paul Carpenter, qui dit avoir été engagé pour réaliser l’appel hypertruqué, a affirmé que cela « a pris moins de 20 minutes et n’a coûté qu’un dollar ». Il a été payé 150 dollars pour le réaliser.

Le faible coût, la facilité de production et l’absence générale de conséquences juridiques constituent une excellente incitation pour quiconque possède les compétences nécessaires pour faire la même chose et a une cible en tête.

Par conséquent, le gouvernement fédéral doit élaborer une législation qui accroît la transparence et criminalise l’utilisation de l’intelligence artificielle à des fins de désinformation, en particulier le partage d’hypertrucages nuisibles.

La pornographie hypertruquée a de véritables conséquences sur les femmes

Le temps pour une loi sur l’intelligence artificielle est arrivé

Il existe déjà des précédents dans le monde en ce qui concerne la manière dont les lois et les règlements pourraient prendre forme. Outre la No AI FRAUD Act, on peut trouver un autre modèle pour établir un cadre fédéral contre les abus de l’IA auprès de la U.S. Federal Communications Commission qui a rendu illégal pour les auteurs d’appels téléphoniques non sollicités d’utiliser des clones vocaux générés par IA.

En outre, les législateurs devraient également examiner les possibilités d’une nouvelle législation et d’une obligation de divulgation volontaire de la part des grandes entreprises technologiques et des plateformes de médias sociaux.

Pour lutter contre l’ingérence électorale, une législation spécifique interdisant l’utilisation des hypertrucages dans les opérations d’influence serait également nécessaire. Par exemple, la Election and Recall Act taïwanaise a ajouté des clauses spécifiques visant à empêcher l’utilisation de faux audios et vidéos.

Si une législation canadienne est nécessaire dans les plus brefs délais, elle ne réglera pas à elle seule ce problème. Une approche globale de la société est nécessaire.

Récemment, j’ai également proposé 10 recommandations politiques concrètes que le Canada pourrait tirer du réseau décentralisé de Taïwan pour renforcer sa résilience démocratique.

Le Canada est déjà loin derrière de nombreuses autres démocraties aux idéologies similaires. Il est temps d’abandonner les beaux discours et d’adopter une politique plus ferme.